Rechtfertigt für mich keine 1.000 Euro für ein HDR untaugliches Gerät.

ich denke die Hz treiben den Preis eben ordentlich nach oben und weil sie deshalb natürlich “Gaming” draufklatschen können.

In diesem Gamestar Artikel wird erklährt wie Nvidia auf soviele Shader-Einheiten kommt.

Ich kenne mich 0 mit diesen Höchstkomplexen Strukturverbesserung aus aber wenn ich den Artikel richtig verstanden habe. Es wirkt so wie als hätte hier Nvidia ein sehr gute Strukturverbesserung entwickelt. Ich Vermute mal das AMD nicht damit gerechnet hat und auch in der kürze der Zeit nicht ähnliche Strukturverbesserungen vornehmen kann.

Bzw ob RDNA2 wirklich so gut sein kann und bei geringerer Shaderanzahl das kompensieren kann waage ich mal zu bezweifeln.

Hab auch einen Youtuber gesehen der meinte das bis zum 17.09 AMD endlich mit Big Navi an die öffentlichkeit gehen muss durch RTX 2080 realease. Wäre cool wenn wir hierzu endlich mal etwas höhren. Oder AMD hält sich still und redisignt ihre Chips mit mehr Schader

kann man nicht wirklich vergleichen, da die architektur von AMD chips im grafikbereich komplett anders ist als die von nvidia. das macht direkte vergleiche zwischen takt, kernzahl etc auch nicht wirklich sinnvoll, anders als zum beispiel bei ner CPU.

schon allein der punkt, dass AMD ja mit einem fortschrittlicheren technologieknoten arbeitet als nvidia, erzeugt einfach zu viele unterschiede, um auf technischer ebene einen 1zu1 vergleich machen zu können. am ende muss man schauen, was der leistungsoutput der karten selbst ist.

Mir ist das klar das keine 1:1 vergleichbarkeit durch Shader gemacht werden kann, Besonders von AMD zu Nvidia…

Aber es ist auch verständlich das wir gamer irgend einen wert benötigen mit dem man zumindest im Genarationswechsels eines Herstellers eine vergleichbarkeit durch eine Steigerung von irgendetwas der Vorherigen genaration festmachen kann.

Natürlich kommt immer ein Watt/Performance plus durch Strukturverkleinerung zustande die meist ja in % vom Herrsteller ausgedrückt wird. (RDNA1 VS. RDNA2)

Troz alledem ist in meiner eingekrusteten Wahrnehmung immer noch eine Steigerung der Rechenkerne (Shader-Einheiten) ein quasi unumgängliches Inditz dafür das etwas voran geht bei der Entwicklung um Performantere Grafikkarten zu bekommen.

Tflops ?

naja du musst aber auch bedenken, dass laut leaks der neue grafikchip auch bei amd massiv größer wird, trotz strukturgrößenverkleinerung. das heißt, man bekommt nicht nur mehr recheneinheiten auf die selbe fläche unter sondern ergänzt auch nochmal zusätzlich massiv durch mehr fläche.

Sagen auch nichts aus. Die letzten AMD Karten hatten doch glaube ich sogar mehr TFlops als Nivida HighEnd und waren trotzdem schlechter.

Ich vergleiche gerne damit nur wir hier leider auch immer öfter von Experten erwähnt das diese sich nicht 1:1 in Spielen wiedergeben leider. Naja wir brauchen nicht länger über keine möglichkeit von vergleichswerten amd zu Nvidia diskutieren. TFlops sin zumindet der Beste richtwert den es gibt.

Einfach abwarten irgendwan wird Big Navi ja komnen und durch Tests werden wir erfahren wie es darum steht.

ich würde ja einfach das endergebniss als vergleich nehmen: fps in spielen

Hat irgendwo irgendjemand irgendwas bestätigtes von den nächsten AMD GraKas gehört? Sonst wäre ich bereit die NVIDIA 3000 Serie jetzt vorzubestellen.

Ich überlege sogar mir wegen der neuen GraKa nen neuen Monitor zu kaufen.

I feel you. Ich will mir seit 2 Monaten nen neuen Rechner kaufen, aber halte mich logischer Weise zurück. So langsam juckt es mich so richtig. Man sollte aber vernünftiger WWeise min bis zu den ersten Tests der Karten warten.

Bei mir ist es zum Glück nur die Grafikkarte.

Bei einem komplett neuen PC wäre ich auch noch ungeduldiger. Das Hands On von Digital Foundry reicht mir schon aus, um NVIDIA zu vertrauen. Das Einzige was jetzt kommen kann ist AMD mit RayTracing und super Leistung für weniger Geld bei gleichem oder niedrigeren Stromverbrauch. Das wäre dann so eine Überraschung wie der erste Ryzen.

Die Monitorhersteller sind große Profiteure von der 3000er Gen.

Ein kumpel frägt auch schon was er sich für einen Monitor holen soll für die 3070. Bisher hat er nur in 1080p 60hz gezockt. Ich weiß nicht so richtig was ich ihm empfehlen soll wqhd 27 zoll 144hz

Uwqhd ?? Zoll 144hz

Oder schon 4k wobei das für ihn warscheinlich zu teuer wird🤔

Ich werd mir WQHD 144Hz holen. Hab Bock auf mehr Frames und 4k ist bei der Nähe zum Monitor eh sinnlos.

4k für Gaming an Desktops auf 27" ist ziemlich verschwendete Leistung. UWQHD ist imo das beste was man mit seiner GPU Power anstellen kann.

Aber ich wäre vorsichtig das jemanden zu geben der keine Ahnung hat wie man evtl mal selbst nen Community Patch oder sowas einspielt falls ein Game mal keine 21:9 Unterstützung hat.

Die meisten, die ich kenne, haben deutlich modernere Monitore als ich. Ich habe immer hohe Einstellungen vor FPS gestellt. Deshalb habe ich auch keinen 144 Hz Monitor. Ich würde jetzt auf jeden Fall G-Sync dazunehmen! Wahrscheinlich auch G-Sync HDR. Ultrawide finde ich zum Arbeiten mega praktisch aber zum zocken ist das irgendwie unausgereift. Dann müsste man die Spiele im Fenstermodus laufen lassen und hätte links und rechts daneben den Desktop. Ich weiß nicht, wie immersiv das ist. Selbst manche neue Spiele sind noch nicht Ultrawide-ready und dann verzerrt sich das Bild am Rand des Monitors wie bei einer GoPro. Auf

hätte ich gar keinen Bock  Dann doch lieber nochmal 16:10 als Bildformat (was es leider nicht mehr zu geben scheint, obwohl ich es immer geliebt habe - genau wie 3:2 bei Laptops).

Dann doch lieber nochmal 16:10 als Bildformat (was es leider nicht mehr zu geben scheint, obwohl ich es immer geliebt habe - genau wie 3:2 bei Laptops).

Ich warte aber mit dem Monitor auf jeden Fall bis zum Kauf der GraKa, weil AMD FreeSync und NVIDIA G-Sync und so.

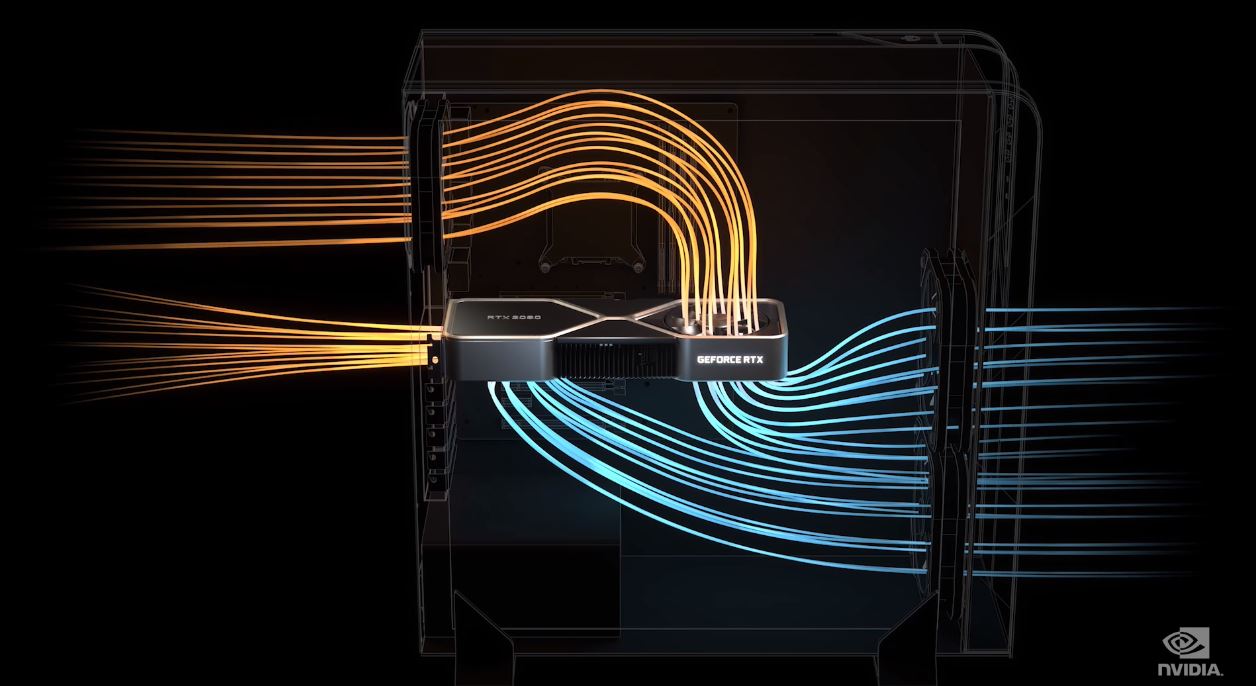

Ich würde im Fall der 3000er sogar zur Founders Edition greifen, weil mir das Kühlerdesign so gut gefällt.

Was meinen die bei Reddit damit?

It does seem like the leaked design would create problems in sandwich cases because the fan on the right side won’t have any space to draw air in and exhaust from the side panel