Ist doch in Baldur’s Gate 3 genauso

Das ging da aber unter weil die Faschisten sich lieber daran aufgehangen hat, das man Sex mit nem Bären(?) haben kann.

Das hat man doch auch bei Cyberpunk und Elden Ring.

Deswegen ist es auch umso entlarvender wenn man bei solchen Leuten mal durch die Bibliothek scrollt und eines dieser Spiele oder sogar beide findet.

Einfach nur traurig. Diese Vollidioten treiben sich echt überall rum. Schlimm, dass die Moderation dort nicht funktioniert.

V.a. ist ja nicht so, als würden diese Spiele es einem verunmöglichen einen Cis-Mann oder was auch immer zu spielen. Man hat einfach mehr Freiheiten in der Charaktergestaltung.

Gefühlt hat grad auf Steam auch die Menge dieser Idioten die sich trauen die Klappe aufzureißen zugenommen. Seit die freiwlligen communitymoderatoren komplett ersetzt wurdenwird es schlimmer und die neuen Moderatoren verteilen wesentlich seltener perma bans als die alten mods.

Ja aber darum geht es denen halt nicht.

Gestern kam das neue Daymare raus. Da wird sich natürlich drüber aufgeregt, dass es nicht genug Charakterauswahl gibt und man gezwungen wird eine Frau zu spielen.

Es geht also eindeutig nur um Ablehnung, egal um welchen Preis und egal mit welchen fadenscheinigen Argumenten.

Krass. Was für ein unglaublich dummer Move von Steam… Gerade in diesen Zeiten ist gute Moderation so wichtig. Weshalb wurden die alten Mods ersetzt?

ja dazu kommen dann noch die playstation ultras und man kann die userwertungen in die tonne kloppen

schade, gerade bei so einem Spiel hätte es mich interessiert

Ein genauen oder gar offiziellen Grund weiss ich nicht, nur dass die alten mods schon ahnten das es passieren würde.

Es ist ja nicht so als ob es mit den community mods keine Probleme gab. Ich bin selbst oft genug mit denen zusammengerasselt um das zu wissen. Und Vorzugsbehandlung von Freunden und Bekannten war halt auch bekannt wodurch manche Leute einen Freifahrtschein hatten sich alles zu erlauben weil der befreundete Moderator dann einfach die reports verschwinden ließ.

Der Unterschied ist vorallem, dass die alten mods proaktiv gehandelt haben. Wenn die ein Thread gesehn haben bei dem schon der bloße Titel diverse Regelverstöße enthielt dann wurd der halt gelöscht und gut ist. Die neuen Mods agieren rein reaktiv, wenn was nicht gemeldet wird dann bleibts halt stehn. Um das ganze noch schlimemr zu machen wurde nach der Umstellung am Wochenende gefühlt garnicht moderiert und da gings dann im Forum drunter und drüber bis am Montag irgendwann mal aufgeräumt wurde. Das hat sich inzwischen zwar gebessert, aber ich frage mich ehrlich wie viele paid mods dort überhaupt zuständig sind. Glaube irgendwie nicht, dass es mehr sind als vorher volunteer mods und von denen gabs gegen Ende so grad mal 35 für ganz Steam.

Das MS AoE Forum + Offizieller Discord haben afaik 3 bezahlte MOds/CommunityManager (die haben aber auch zusätzlich andere Tätigkeiten wie der Name sagt  ) + freiwilige Mods.

) + freiwilige Mods.

Ich bezweifle mal das Steam trotz der größe dessen Forums allzu viel mehr eingestellt hat

Frage mich ja, ob sie für die Erkennung von sowas zukünftig eher auf Abkömmlinge von GPT Netzen setzen, statt auf Mods. An sich versteht ChatGPT derzeit ja Kontext und Inhalt schon extrem gut.

ChatGPT stellt sich selbst dazu folgendes Urteil aus:

The feasibility of utilizing a GPT-like bot for the purpose of detecting and erasing hate comments is indeed a topic of interest. Hate speech detection and moderation is a complex challenge in the realm of natural language processing (NLP) and artificial intelligence (AI). While the potential application of advanced language models such as GPT-3.5 in this context is theoretically plausible, there are several critical considerations that must be addressed to determine its practical viability.

To assess the viability of employing a GPT-like bot for hate comment detection and eradication, we must consider the following points:

- Training Data : The effectiveness of any AI model, including GPT-like models, heavily relies on the quality and diversity of the training data. A significant volume of accurately labeled hate speech data is required to train the model to distinguish between hateful and non-hateful content.

- Bias and Fairness : Language models like GPT-3.5 can inadvertently learn biases present in the training data. Special attention must be paid to ensure that the model does not perpetuate or amplify existing biases during its hate speech detection efforts.

- Contextual Understanding : Hate speech often involves nuanced language and context-dependent expressions. A robust model must be able to accurately comprehend the context in which certain words or phrases are used to determine whether they are genuinely offensive.

- False Positives and Negatives : Striking a balance between minimizing false positives (legitimate content incorrectly labeled as hate speech) and false negatives (actual hate speech not detected) is a critical challenge. The model should not over-censor valid speech while effectively identifying harmful content.

- Constant Learning and Adaptation : The landscape of hate speech is dynamic, with new terms and expressions emerging continually. The model should be capable of learning and adapting to evolving patterns of hate speech to remain effective over time.

- User Intent Recognition : Differentiating between hate speech and instances where users are discussing hate speech for educational or awareness-raising purposes is crucial. The model must accurately distinguish intent behind the language.

- Ethical and Privacy Concerns : The use of AI for content moderation raises concerns about privacy, surveillance, and the potential for censorship. Transparency in the moderation process and clear guidelines for users are essential.

- Human Oversight : Human moderation and oversight remain crucial. An AI model, no matter how advanced, may not be able to fully replace human judgment in evaluating complex social and cultural contexts.

In conclusion, while the potential of GPT-like bots for hate speech detection and removal is promising, it is not without challenges. Ethical, technical, and societal considerations must be carefully navigated to develop an effective and responsible system. Collaboration between AI developers, content platforms, and experts in linguistics, ethics, and sociology is essential to ensure that such a system is deployed in a way that respects both freedom of expression and the need to mitigate online harm.

Verstehe, danke für die Erklärung. Ich finde es irgendwie beängstigend, dass auf so einer riesigen Plattform so lasch und unterbesetzt moderiert wird. Zeigt, dass die Unternehmen sich der Gefahr nicht bewusst sind oder es ihnen egal ist.

Das

Bewusst sind die Probleme jedem der 5 Sekunden in dem Forum war oder sich nen Bericht anhört

Daher ist es einfach Desinteresse bzw das Geld für die nicht wert.

BG3 Steam Forum hat auch ständig solche Kommentare und Threads.

Oh kein Starfield für PS5

Naja dann halt mit GamePass am PC für quasi gratis

Der post von meinem screenshot oben ist jetzt gelöscht worden. Hat mein report also doch was gebracht. Allerdings ist der Thread mit allen anderen posts weiterhin da.

Zeigt einfach das dort null Initiative herrscht auch nur irgendwas zu moderieren solang es keine reports gibt, nur ist es halt so viel, dass man mit reporten garnicht hinterher kommt.

Normalerweise müsste Bethesda vorübergehend den Zugriff aufs Forum beschränken, so dass nur Leute posten können die das Spiel besitzen (ist ne Standartfunktion von Steam btw) und dann erstmal ordentlich durchwischen. Aber sein wir ehrlich das wird nicht passieren.

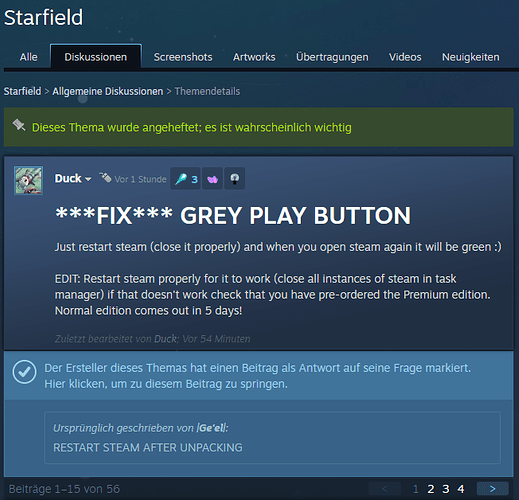

Und irgenden jemand von Bethesda muss sich dort im Forum rumtreiben, denn schließlich wurde ein Thread von einem user angepinnt der weniger als eine Stunde alt ist.

Ansonten aber weit und breit kein mod, admin oder dev zu finden in den posts.

Ist die Frage ob man das bspw irgendwie an jemanden von MS bekommt, die mogen sowas eigentlich nicht. Also naturlich auch nur weil es äußerst schlechte PR sein kann.